Ecucha La Radio en linea

viernes, 28 de noviembre de 2025

martes, 25 de noviembre de 2025

viernes, 21 de noviembre de 2025

La naturaleza te juzga

https://www.tparents.org/Moon-Talks/SunMyungMoon07/SunMyungMoon-070511.htm

La naturaleza te juzga.

Sun Myung Moon

, 11 de mayo de 2007.

Hoon Dok Hae

Cheon Jeong Gung.

FFWPU International.

Traducción de notas no oficiales tomadas por el Comité de Compilación de la Historia de la Iglesia de la Unificación.

Sun Myung Moon, 8 de agosto de 2010

Resumen de las palabras del padre:

(Recordando la época en que escribió el poema «Corona de Gloria») La naturaleza te juzga. Oré en un lugar terrible. Mi familia y mi nación estaban en una situación desesperada. Todos en quienes confiaba fueron castigados… No entendía por qué las cosas habían llegado a ese punto… todo era por mi culpa… La esperanza de Jesús era que viniera alguien que pudiera resolverlo todo. Dios también decía que era incapaz de hacerlo y, por eso, me pedía a mí, a través de Jesús, que lo hiciera.

Sabiendo esto, ¿crees que podría vivir como quisiera? No comía; no dormía. Los brazos y las piernas de este joven se le doblaban sin que se diera cuenta. Se desplomaba en el suelo y se dormía. Se levantaba aunque estuviera demasiado agotado para mantenerse en pie. Aun así, se esforzaba y actuaba, sabiendo que tenía que levantarse y seguir adelante. Así es como he llegado hasta aquí. Así es como me esfuerzo incluso hoy.

Si te ríes de los mensajes de paz o haces bromas al respecto, te caerá un rayo. Debes saber que publiqué este folleto con la esperanza de que te conviertas en alguien que pudiera formar parte del grupo de amigos o camaradas que sanaron mis heridas en los momentos difíciles; alguien que pudiera ser parte del grupo de guerreros en la batalla; alguien que pudiera morir conmigo y ser enterrado juntos en un cementerio público, y prometer convertirse en un soldado celestial al llegar al cielo.

Cuando las mujeres de la Iglesia de la Unificación salían a predicar y a recorrer caminos difíciles, el Cielo las guiaba por el sendero que las uniría con sus prometidos. Yo las guiaba, les enseñaba y las criaba. ¿Cómo podrían olvidarlo? Ese es el tipo de pasado que tienen. Lo mismo ocurre con los hombres. Clamaban por encontrarme. «¿Cómo puedo encontrar a esos miembros (que se fueron)? Desaparecieron sin dejar rastro». Los busqué incansablemente. A veces me tomaba un año, incluso dos, encontrarlos. Aun así, brindaba guía espiritual a personas en situaciones difíciles.

Por eso es diferente. Los embajadores de la paz deberían pasar por esa experiencia a partir de ahora. No tienen ninguna forma de conectarse conmigo. Todos ustedes están establecidos (en la sociedad) y viven bien. Todos ustedes desprecian a la Iglesia de la Unificación. Yo los considero embajadores de la paz. Están en la posición del arcángel, el arcángel que no cumplió con su responsabilidad. Viven en la fortuna solo porque se les permitió; no obtuvieron el éxito por la autoridad de esta nación. Llevaron una vida fácil gracias al legado de sus antepasados, pero eso no significa nada para mí.

Así es como te veo. Recientemente permití que los hijos de los embajadores de la paz recibieran la bendición entre sí. ¿Por qué? Entre los embajadores de la paz hay algunos que sirvieron en el gobierno como ministros o presidentes. Había gente de todo tipo. Sin embargo, todos pensaban: «No recibiré la bendición a menos que mi pareja sea alguien que haya ocupado un cargo ministerial o superior». Pensaban: «Solo trabajaré en tal o cual puesto».

Bueno, adelante, busquen ese "puesto". Intenten encontrarlo eternamente. Jamás lo encontrarán. Para encontrar un lugar así, hay que ser como un niño y vivir pensando en todos los que están allí, en sus hermanos y familiares. Hay que aprender de ellos. Sin embargo, estos embajadores de la paz buscan ser atendidos y tratados con respeto. No permitiré que se preparen asientos especiales para estas personas ajenas a la comunidad. Dondequiera que vayan, incluso a una de nuestras reuniones, se sientan al fondo.

Pensaban que yo iría solo porque me habían invitado. Los miembros de cierta iglesia que me invitaron se preparaban, orando desde temprano. Cuando me presentaba ante ellos por la mañana, quienes habían orado, sin saber quién era, me trataban con rudeza. Sin embargo, era a mí a quien esperaban. Esperaban que el conferenciante llegara a la hora prometida. Esperaron (pero no apareció). Una de las figuras de autoridad pensó: «Él (el padre) no puede ser la persona a quien deberíamos buscar y asistir como maestro, dada la dignidad de nuestra iglesia». Así me trataba. Hubo muchas veces en que asistía a una reunión a la hora prometida, solo para recoger mis cosas y regresar sin decir una palabra porque no creían que yo fuera el indicado.

La madre debe perfeccionarse antes del 16 de junio de 2013. Entonces deberá regresar a su posición original. Cuando la madre y el padre se dediquen a Dios, deberán vivir como siervos, enseñando a otros el camino del servicio en el mundo no caído. Deberán enseñar a las personas el camino hacia la perfección; deberán encontrar una nación y mostrarles ese camino. Si tuvieran que pasar por dificultades nuevamente, o si llegara el momento en que ustedes, que han ascendido dentro de la Iglesia de la Unificación, tuvieran que regresar a tales tiempos de adversidad, ¡todos huirían! [¡No, no lo haremos!] ¡Mentiroso! Probablemente todos huirán. Si eres director de escuela, por ejemplo, y los estudiantes están en huelga, ¡tienes que irte! No es tu problema individual.

(6:45 am El padre le pide a la Sra. Dow Soon Choi (72 pareja bendecida) que cante, llamándola "una mujer famosa en la Iglesia de la Unificación".)

Esta señora, Dow Soon Choi, es bastante famosa. Siempre que salía a la batalla, les hacía la vida imposible a cualquiera, hombre o mujer, que se opusiera a la Iglesia de la Unificación. Hacía todo lo que le ordenaban.

Resumen del testimonio de la Sra. Dow Soon Choi:

Mientras esperaba la bendición (para la bendición de las 72 parejas), recuerdo haber visto a un hombre entre los candidatos que parecía algo distraído. No digo que siga siendo así, pero esa fue mi impresión en aquel momento. Sin embargo, al observarlo con más detenimiento, me di cuenta de que era la misma persona de la foto que me dio el Padre en mi sueño, cuando me dijo: «Esta persona es tu prometida». Así fue como conocí a mi difunto esposo (el Sr. Joon Hyung Lee).

Mi padre me dijo que no se arrepentiría de nada cuando me viera amamantando a mi bebé. Al oírlo, me preocupé de no poder tener hijos, pero desde entonces he dado a luz a tres. Tras recibir la bendición, fui a mi zona de misión. Fueron tiempos difíciles; tuve que vivir en una habitación pequeña con los padres y hermanos de mi esposo. Después de que mi esposo dejara Il Hwa, nos dedicamos al negocio del arroz. Yo tenía la fuerza suficiente para subir un saco de arroz de 40 kg hasta un quinto piso. Mi esposo, en cambio, no tenía la fuerza suficiente para cargar un saco él solo.

Viví en Cheolwon-gun (Dongsong-myun) durante 51 años. Sin embargo, nuestra iglesia sigue estando muy deteriorada. Si fuera posible, desearía que se reconstruyera el edificio.

(Después de que la Sra. Choi terminara su testimonio, el Padre dio instrucciones sobre el apoyo que debía brindarse para la reconstrucción de la iglesia en Cheolwon).

jueves, 20 de noviembre de 2025

factura cripts para su negocio

FacturaScripts es un software libre pensado para simplificar la gestión diaria de su empresa. Le permite trabajar de forma ágil y completa con:

- Facturas y recibos

- Gastos y presupuestos

- Pedidos, albaranes e inventario

- Contabilidad, informes y modelos fiscales

Ideal para autónomos y pymes. Fácil de personalizar gracias a más de 140 plugins disponibles para adaptar el sistema a sus procesos.

Cumple la normativa vigente en España, Argentina y Ecuador y está preparado para integrarse con Verifactu, TicketBAI, SII (España), AFIP (Argentina) y SRI (Ecuador).

miércoles, 19 de noviembre de 2025

martes, 18 de noviembre de 2025

Noticias internacionales

lunes, 17 de noviembre de 2025

domingo, 16 de noviembre de 2025

viernes, 14 de noviembre de 2025

Aquella mujer que Ora pidiéndole a Dios , por mi y por toda la humanidad , la tienen en la cárcel

"Petición por la liberación del Dr. Hak Ja Han: Más allá de la religión"

Traducción automática de un artículo de la revista "Seonggi Ilbo"

https://n.news.naver.com/mnews/article/022/0004082411?sid=103

"Petición por la liberación del Dr. Hak Ja Han: Más allá de la religión"

Más de 50 líderes religiosos de todo el mundo ofrecieron una rueda de prensa

en apoyo a los valores y la conciencia religiosa de la Federación de Familias.

"Debe cesar la presión injustificada sobre el Dr. Han, quien se ha dedicado a la paz mundial".

El Comité Organizador de la Concentración Mundial Interreligiosa por la Paz y la Libertad Religiosa del Clero ofreció una rueda de prensa frente a la estatua del Rey Sejong el Grande en Gwanghwamun, Seúl, la tarde del jueves 13, y emitió un comunicado en apoyo a los valores y la conciencia religiosa de la Federación de Familias para la Paz y la Unificación Mundial.

Más de 50 líderes religiosos destacados participaron en la rueda de prensa, entre ellos el reverendo Thomas Barrett (Iglesia Christ Gad Center), reconocido evangelista estadounidense; el Arzobispo Crisóstomo Celi (Arzobispo de la Iglesia Ortodoxa Oriental de Sudamérica); Sranci Lewis (Arzobispo de la Misión Internacional de Liberación de Sión, Little Rock); y Anne Lalo (Iglesia Católica de Santo Tomás). También asistieron el reverendo Seo Jin-woo, copresidente del Consejo Coreano del Clero Cristiano (KCLC), así como líderes de diversas religiones coreanas, como el budismo, el islam, el catolicismo, el donghak y el confucianismo.

En su declaración, afirmaron:

«La humanidad actual ha alcanzado un progreso notable en ciencia, tecnología y desarrollo material, pero paradójicamente, los valores de la espiritualidad y la fe están en declive. Sin embargo, la civilización humana siempre se ha cimentado firmemente en la fe, la conciencia y los valores espirituales. La libertad religiosa es el derecho más universal de la humanidad y el eje espiritual central de la civilización. Exigimos con vehemencia el cese inmediato de la injusta presión ejercida sobre la Reverenda Hak Ja Han Moon, quien ha dedicado su vida a la visión de la paz mundial y al movimiento por la paz religiosa, y que su absolución marque un hito histórico en la restauración de la libertad religiosa y el renacimiento de la conciencia de toda la humanidad».

Además, hicieron un llamamiento:

«Instamos encarecidamente a la comunidad internacional a que se solidarice responsablemente para prevenir mayores daños a la libertad religiosa y a los valores espirituales».

A continuación, declararon las siguientes cuatro resoluciones: 1. El cese inmediato de la discriminación y la opresión injusta que atentan contra la libertad religiosa, y la máxima protección de la conciencia y la dignidad de los creyentes.

2. Construir una solidaridad basada en la verdad y la espiritualidad para el respeto y la armonía interreligiosa, y presentar un modelo ejemplar de convivencia y armonía para la sociedad humana.

3. La necesidad de una solidaridad y una acción responsables por parte de la comunidad internacional en favor de la libertad de conciencia y la libertad religiosa.

4. Apoyar la visión de paz y solidaridad espiritual que promueve la Iglesia de la Unificación y ampliar la cooperación interreligiosa para el futuro de la humanidad.

Además, los líderes religiosos que participaron en la "Marcha Mundial de Líderes Religiosos por la Paz y la Libertad Religiosa", celebrada ese mismo día, declararon solemnemente: "Eliminaremos resueltamente todas las formas de discriminación y los actos de odio, y trabajaremos juntos para lograr una sociedad justa, pacífica y civilizada basada en el respeto y la comprensión".

Mientras tanto, en Seúl, desde el día anterior hasta el 15, se celebró la "Marcha Mundial Interreligiosa por la Paz y la Libertad Religiosa del Clero", copatrocinada por el KCLC, el Consejo Mundial del Clero Cristiano (WCLC), el Consejo Coreano de Religiones (KRA) y la Iglesia de la Unificación Familiar. El evento incluyó una reunión de oración interreligiosa por la paz y una vigilia de oración nocturna frente al Centro de Detención de Seúl.

https://n.news.naver.com/mnews/article/022/0004082431?sid=103

Muchas gracias

«La detención de la Dra. Hak Ja Han representa un revés para la libertad religiosa mundial»

Chrysostomos Celi, Patriarca de la Iglesia Ortodoxa de Sudamérica

«Líderes religiosos de todo el mundo se mostraron consternados por la noticia de la detención de la Dra. Hak Ja Han. Resulta difícil comprender que la libertad religiosa se vea amenazada en Corea, un país desarrollado y con un alto nivel educativo».

El Patriarca Arzobispo Chrysostomos Celi (53), de la Iglesia Ortodoxa de Sudamérica, declaró esto en una entrevista con el Segye Ilbo el día 13: «Visité Corea para ver la situación de primera mano».

Su visita a Corea tuvo como objetivo representar a la Iglesia Ortodoxa en la «Marcha Interreligiosa por la Paz y la Libertad Religiosa», que se celebrará en Seúl del 12 al 15.

El evento, celebrado bajo el lema «¡La paz empieza conmigo! ¡Todas las religiones en un mismo camino!», cuenta con la participación de organizaciones como el Consejo Coreano de Religiones, el Consejo Mundial del Clero Cristiano (CMCC) y el Consejo Coreano del Clero Cristiano (CCCC).

El patriarca Arzobispo Celi, quien visita Corea por segunda vez, afirmó: «El pueblo coreano es generoso y hospitalario. Recuerdo bien cómo me recibieron, siendo yo extranjero, como a un miembro más de la familia».

Añadió: «La reverenda Hak Ja Han ha logrado reunir a diversos líderes religiosos y construir un nuevo foro de cooperación», y elogió: «La alianza que ha liderado infunde un profundo sentido de solidaridad».

El Arzobispo Celi, doctor en filosofía, teología, restauración de arte y literatura, ha promovido activamente la libertad religiosa y los derechos humanos en Sudamérica. Participó en la promulgación de la Ley de Libertad Religiosa de Ecuador durante más de 15 años y actualmente colabora en la redacción de una nueva constitución.

Respecto al panorama religioso en Sudamérica, el Arzobispo Celi explicó: «Tradicionalmente, el catolicismo ha sido dominante, pero en los últimos años la diversidad ha ido en aumento. En este contexto, la protección de los valores de la familia y la fe se ha convertido en un tema crucial».

Enfatizó: «La Reverenda Hak Ja Han nos ha mostrado una nueva forma de resolver estos conflictos y es una figura muy querida por los líderes sudamericanos».

Como representante de más de 6.000 iglesias en Ecuador, afirmó: «Espero reunirme con la Reverenda Patriarca Han durante mi visita a Corea. Es mi responsabilidad transmitir con precisión su mensaje y la situación actual de Sudamérica».

Haciendo referencia a la tradición ortodoxa, marcada por la persecución, declaró: «La paciencia y la valentía de la Reverenda Patriarca son un gran ejemplo, y los líderes de la Iglesia ortodoxa en Sudamérica oran por su liberación».

El Arzobispo Celi no ocultó su preocupación por la detención de una líder religiosa de avanzada edad.

«Yo mismo cuido de mi madre, que tiene más de 80 años, y comprendo perfectamente las dificultades que afrontan las personas mayores. Cualquier medida que se tome debe ser justa y basarse en la ley y la justicia. Esta situación no es solo un problema de Corea; los líderes religiosos de todo el mundo la siguen de cerca», afirmó. Continuó: «La Iglesia Ortodoxa tiene la tradición de superar los conflictos dentro de diversas comunidades y de aprender la "unidad en medio de las diferencias". Al igual que internet, el mundo actual ya no desea la división. La división de la península coreana también terminará, sin duda».

Lamentó: «El reverendo Han fue quien transmitió al mundo la realidad de la división de Corea y difundió un mensaje de unificación y paz. La detención de una persona así nos obliga a reconsiderar qué podemos aprender de Corea y qué tipo de paz debemos buscar».

https://n.news.naver.com/mnews/article/022/0004082411?sid=103

Muchas gracias

¡ Oren por su liberación, tanto dentro como fuera del país! Dijo la Madre Verdadera

¡ Oren por su liberación, tanto dentro como fuera del país!

La siguiente noticia fue publicada como noticia de última hora. Si bien aún es pronto para predecir el futuro, el Tribunal Central del Distrito de Seúl aceptó la solicitud de libertad bajo fianza de la Reverenda Hak Ja Han, lo que genera esperanza de su liberación.

[Noticia de última hora 14/11] Aceptada la solicitud de libertad bajo fianza de la Reverenda Hak Ja Han: Movimiento para la Corrección de Detenciones Injustas Exige Consideración de la Salud de los Ancianos

14 de noviembre: En medio de la creciente atención en Corea del Sur sobre la protección de los derechos humanos de los ancianos, se supo el 14 de noviembre que la Reverenda Hak Ja Han (82), líder de la Federación de Familias (antes Iglesia de la Unificación), solicitó la libertad bajo fianza ante el Tribunal Central del Distrito de Seúl el 13 de noviembre. Alegando deterioro de su salud, solicita su liberación de una detención prolongada e injusta. El tribunal aceptó la solicitud y está programando una fecha para la audiencia.

13 de noviembre de 2025 (el día anterior). El mismo día, el presidente solicitó formalmente la libertad bajo fianza ante la 27ª Sala Penal del Tribunal Central del Distrito de Seúl (Juez Presidente: Woo In-seong).

Los principales motivos para la solicitud de fianza son los problemas de salud del presidente, derivados de su avanzada edad. En concreto, su recuperación tras la cirugía de glaucoma no ha sido suficiente y el entorno de detención está aumentando su carga física y mental.

El presidente ha solicitado reiteradamente medidas humanitarias que tengan en cuenta su salud y la rectificación de su injusta detención. Al parecer, en su solicitud ha propuesto la libertad condicional, como el pago de una fianza y la monitorización de su ubicación.

Proceso paso a paso en caso de concesión de la fianza:

Si el tribunal aprueba la fianza (conocida como «libertad bajo fianza» o «libertad condicional mediante el pago de una fianza» según la legislación coreana), es probable que el presidente sea puesto en libertad de inmediato.

Audiencia de fianza (en un plazo de 1 a 2 semanas): El tribunal examinará los argumentos del presidente y las consideraciones procesales. Se revisarán los certificados de salud y las medidas para evitar la fuga (confiscación del pasaporte, restricciones de residencia). En los casos en que el motivo de la detención sea la edad avanzada, la tasa de aprobación es relativamente alta y se prevé flexibilidad en las decisiones, teniendo en cuenta la edad del presidente.

El presidente podrá regresar a su domicilio o a un hospital cercano a Seúl para descansar y recuperarse.

jueves, 13 de noviembre de 2025

«La detención de la Dra. Hak Ja Han representa un revés para la libertad religiosa mundial»

«La detención de la Dra. Hak Ja Han representa un revés para la libertad religiosa mundial»

Chrysostomos Celi, Patriarca de la Iglesia Ortodoxa de Sudamérica

«Líderes religiosos de todo el mundo se mostraron consternados por la noticia de la detención de la Dra. Hak Ja Han. Resulta difícil comprender que la libertad religiosa se vea amenazada en Corea, un país desarrollado y con un alto nivel educativo».

El Patriarca Arzobispo Chrysostomos Celi (53), de la Iglesia Ortodoxa de Sudamérica, declaró esto en una entrevista con el Segye Ilbo el día 13: «Visité Corea para ver la situación de primera mano».

Su visita a Corea tuvo como objetivo representar a la Iglesia Ortodoxa en la «Marcha Interreligiosa por la Paz y la Libertad Religiosa», que se celebrará en Seúl del 12 al 15.

El evento, celebrado bajo el lema «¡La paz empieza conmigo! ¡Todas las religiones en un mismo camino!», cuenta con la participación de organizaciones como el Consejo Coreano de Religiones, el Consejo Mundial del Clero Cristiano (CMCC) y el Consejo Coreano del Clero Cristiano (CCCC).

El patriarca Arzobispo Celi, quien visita Corea por segunda vez, afirmó: «El pueblo coreano es generoso y hospitalario. Recuerdo bien cómo me recibieron, siendo yo extranjero, como a un miembro más de la familia».

Añadió: «La reverenda Hak Ja Han ha logrado reunir a diversos líderes religiosos y construir un nuevo foro de cooperación», y elogió: «La alianza que ha liderado infunde un profundo sentido de solidaridad».

El Arzobispo Celi, doctor en filosofía, teología, restauración de arte y literatura, ha promovido activamente la libertad religiosa y los derechos humanos en Sudamérica. Participó en la promulgación de la Ley de Libertad Religiosa de Ecuador durante más de 15 años y actualmente colabora en la redacción de una nueva constitución.

Respecto al panorama religioso en Sudamérica, el Arzobispo Celi explicó: «Tradicionalmente, el catolicismo ha sido dominante, pero en los últimos años la diversidad ha ido en aumento. En este contexto, la protección de los valores de la familia y la fe se ha convertido en un tema crucial».

Enfatizó: «La Reverenda Hak Ja Han nos ha mostrado una nueva forma de resolver estos conflictos y es una figura muy querida por los líderes sudamericanos».

Como representante de más de 6.000 iglesias en Ecuador, afirmó: «Espero reunirme con la Reverenda Patriarca Han durante mi visita a Corea. Es mi responsabilidad transmitir con precisión su mensaje y la situación actual de Sudamérica».

Haciendo referencia a la tradición ortodoxa, marcada por la persecución, declaró: «La paciencia y la valentía de la Reverenda Patriarca son un gran ejemplo, y los líderes de la Iglesia ortodoxa en Sudamérica oran por su liberación».

El Arzobispo Celi no ocultó su preocupación por la detención de una líder religiosa de avanzada edad.

«Yo mismo cuido de mi madre, que tiene más de 80 años, y comprendo perfectamente las dificultades que afrontan las personas mayores. Cualquier medida que se tome debe ser justa y basarse en la ley y la justicia. Esta situación no es solo un problema de Corea; los líderes religiosos de todo el mundo la siguen de cerca», afirmó. Continuó: «La Iglesia Ortodoxa tiene la tradición de superar los conflictos dentro de diversas comunidades y de aprender la "unidad en medio de las diferencias". Al igual que internet, el mundo actual ya no desea la división. La división de la península coreana también terminará, sin duda».

Lamentó: «El reverendo Han fue quien transmitió al mundo la realidad de la división de Corea y difundió un mensaje de unificación y paz. La detención de una persona así nos obliga a reconsiderar qué podemos aprender de Corea y qué tipo de paz debemos buscar».

https://n.news.naver.com/mnews/article/022/0004082411?sid=103

miércoles, 12 de noviembre de 2025

sábado, 8 de noviembre de 2025

jueves, 6 de noviembre de 2025

Debian 13 agregar repositorios

Dependiendo de cómo instalaste Debian, sí, la configuración del repositorio podría solo contener el ISO de instalación y nada más. Si ese es el caso, solo vas a necesitar agregar esas líneas en /etc/apt/sources.list

deb http://deb.debian.org/debian trixie main non-free-firmware

deb-src http://deb.debian.org/debian trixie main non-free-firmware

deb http://deb.debian.org/debian-security/ trixie-security main non-free-firmware

deb-src http://deb.debian.org/debian-security/ trixie-security main non-free-firmware

deb http://deb.debian.org/debian trixie-updates main non-free-firmware

deb-src http://deb.debian.org/debian trixie-updates main non-free-firmware

Edit: también podrías querer agregar contrib y non-free, dependiendo de los paquetes que necesites en tu sistema.

miércoles, 5 de noviembre de 2025

Reparar DPKG en linux

Reparar dpkg en Debian 13, primero ejecuta sudo dpkg --configure -a para configurar los paquetes instalados pero no configurados. Si el problema persiste, prueba con sudo apt --fix-broken install para intentar reparar las dependencias rotas.

Reconfigura todos los paquetes: Si tienes problemas específicos

con la configuración de ciertos paquetes, puedes reconfigurarlos individualmente con:

sudo dpkg-reconfigure <nombre_del_paquete>

Para reiniciar la línea de comandos de Debian, puedes usar sudo systemctl reboot o el comando simple reboot para reiniciar el sistema completo. Si lo que quieres es limpiar la pantalla de la terminal sin reiniciar el sistema, usa el comando clearPara instalar el entorno de escritorio KDE Plasma en Debian 13, puedes utilizar el metapaquete task-kde-desktop o kde-plasma-desktopActualiza la lista de paquetes e instala las actualizaciones existentessudo apt update && sudo apt upgrade -y

Reconfiguración de paquetes

Si has instalado paquetes que requieren reconfiguración, puedes hacerlo con el siguiente comando:

dpkg-reconfigure locales

dpkg-reconfigure tzdata

Abre la Terminal: Inicia la aplicación de terminal en tu sistema Debian.

Edita el archivo sources.list: Usa el comando sudo nano /etc/apt/sources.list para abrir el archivo de configuración de los repositorios con permisos de superusuario.

Agrega los repositorios:

En Debian 13 se empieza a usar por defecto un nuevo sistema llamado DEB822. En vez de un solo archivo lleno de líneas raras, cada repositorio se define en un archivo separado, con una estructura más clara y ordenada.

Por ejemplo:

cat /etc/apt/sources.list.d/debian.sources

Types: deb

URIs: http://deb.debian.org/debian

Suites: trixie

Components: main contrib non-free non-free-firmware

Signed-By: /usr/share/keyrings/debian-archive-keyring.gpg

https://voidnull.es/adios-sources-list-hola-deb822-como-cambian-los-repos-en-debian-13/#:~:text=va%20a%20cambiar.-,Llega%20DEB822%2C%20el%20nuevo%20formato%20para%20los%20repositorios,estructura%20m%C3%A1s%20clara%20y%20ordenada.

martes, 4 de noviembre de 2025

Actualización a Debian 13

https://blog.cursosdedesarrollo.com/posts/post-016/

En este artículo, te guiaremos a través del proceso de actualización de Debian 11 a Debian 13. Actualizar tu sistema operativo es crucial para mantener la seguridad, estabilidad y acceso a las últimas características. A continuación, te mostraremos cómo realizar esta actualización de manera segura y sencilla. en el link anterior

Pasos para la actualización

Eliminar repositorios de paquetes no oficiales

Evidentemente, necesitaremos estar con acceso root para realizar la actualización. Si no estás seguro de cómo hacerlo, puedes usar el comando su -:

Empezaremos repasando los repositorios de paquetes no oficiales. Esto es importante para evitar conflictos durante la actualización. Abre tu terminal y revisa el directorio /etc/apt/sources.list y cualquier archivo en el directorio /etc/apt/sources.list.d/. Puedes usar el siguiente comando para listar los archivos:

ls /etc/apt/sources.list /etc/apt/sources.list.d/Haz copia de seguridad de estos archivos antes de modificarlos:

cp /etc/apt/sources.list /root/sources.list

mkdir -p /root/sources.list.d/

cp /etc/apt/sources.list.d/* /root/sources.list.d/Ahora lo suyo seŕia borrar los repositorios de terceros del directorio /etc/apt/sources.list.d/ y del archivo /etc/apt/sources.list. Puedes hacerlo con el comando:

sudo rm -f /etc/apt/sources.list.d/*Y por último eliminar el archivo /etc/apt/sources.list.

sudo rm /etc/apt/sources.listConvertir los repositorios a Debian 13

Ahora, vamos a actualizar los repositorios para que apunten a Debian 13. Abre el archivo /etc/apt/sources.list con tu editor de texto favorito, por ejemplo:

sudo nano /etc/apt/sources.list.d/debian.sourcesEl archivo debería verse algo así:

Types: deb

URIs: https://deb.debian.org/debian

Suites: trixie trixie-updates

Components: main contrib non-free non-free-firmware

Signed-By: /usr/share/keyrings/debian-archive-keyring.gpg

Types: deb

URIs: https://security.debian.org/debian-security

Suites: trixie-security

Components: main contrib non-free non-free-firmware

Signed-By: /usr/share/keyrings/debian-archive-keyring.gpgEliminar paquetes obsoletos

Antes de proceder con la actualización, es recomendable eliminar los paquetes que ya no son necesarios. Ejecuta:

apt autoremoveActualizar la lista de paquetes

Una vez que hayas actualizado los repositorios, es hora de actualizar la lista de paquetes. Ejecuta el siguiente comando:

apt updateEsto descargará la información más reciente de los paquetes disponibles en los repositorios de Debian 13.

Actualizar los paquetes instalados

Ahora, actualiza todos los paquetes instalados a sus versiones más recientes disponibles en Debian 13, pero sin instalar los paquetes nuevos. Ejecuta:

apt upgrade --without-new-pkgsSacará un mensaje indicando los cambios de apt. Simplemente presiona q para continuar.

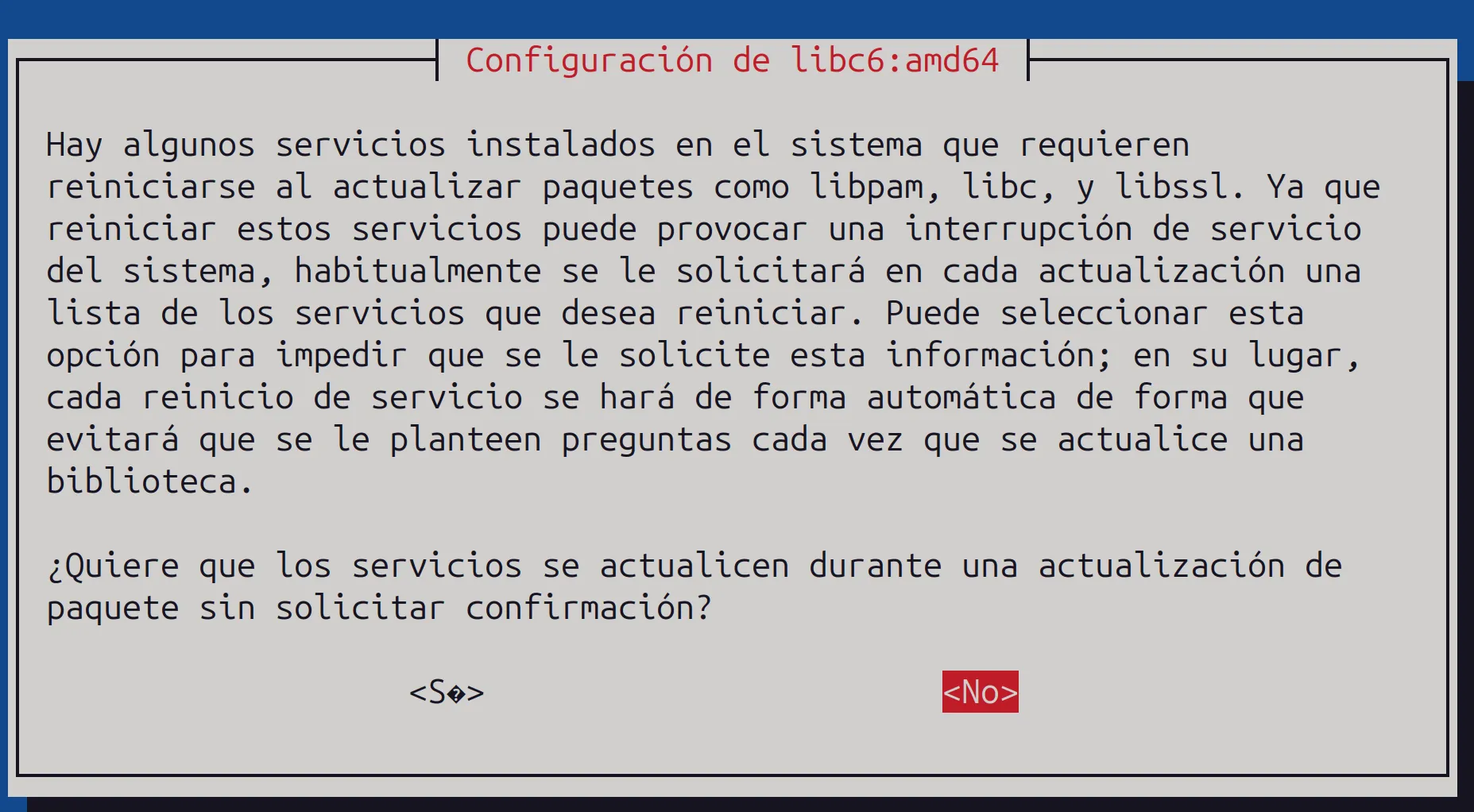

Reinicio de servicios dependientes de libc6. Elige Sí para reiniciar los servicios que dependen de

Elige Sí para reiniciar los servicios que dependen de libc6. Esto es importante para asegurar que los servicios sigan funcionando correctamente después de la actualización.

Actualizar el sistema

Finalmente, actualiza el sistema a Debian 13. Este comando actualizará todos los paquetes y realizará cualquier cambio necesario en la configuración del sistema:

apt full-upgradeSacará un mensaje indicando los cambios de apt. Simplemente presiona q para continuar.

Instalación del metapaquete linux-image-*

Es posible que necesites instalar el metapaquete linux-image-* para asegurarte de que tienes el kernel más reciente. Puedes instalarlo con el siguiente comando:

apt install linux-image-amd64Esto instalará el kernel más reciente disponible para tu arquitectura. Si tienes otra arquitectura, reemplaza amd64 por la arquitectura correspondiente.

Limpiando el sistema

Después de la actualización, es recomendable limpiar el sistema para eliminar paquetes innecesarios y liberar espacio en disco. Ejecuta:

apt autoremoveEsto eliminará los paquetes que ya no son necesarios y liberará espacio en tu sistema.

Reiniciar el sistema

Una vez que hayas completado todos los pasos anteriores, es hora de reiniciar tu sistema para que los cambios surtan efecto. Puedes hacerlo con el siguiente comando:

rebootEsto reiniciará tu sistema y, una vez que se inicie, deberías estar ejecutando Debian 13.

Verificación de la actualización

Para verificar que la actualización se ha realizado correctamente, puedes ejecutar el siguiente comando:

cat /etc/os-releaseCon la salida:

PRETTY_NAME="Debian GNU/Linux 13 (trixie)"

NAME="Debian GNU/Linux"

VERSION_ID="13"

VERSION="13 (trixie)"

VERSION_CODENAME=trixie

DEBIAN_VERSION_FULL=13.0

ID=debian

HOME_URL="https://www.debian.org/"

SUPPORT_URL="https://www.debian.org/support"

BUG_REPORT_URL="https://bugs.debian.org/"Esto confirmará que estás ejecutando Debian 13 (Trixie).

Pasos post-reinicio

Después de reiniciar, es recomendable realizar algunos pasos adicionales para asegurarte de que tu sistema está completamente actualizado y funcionando correctamente.

Verificar actualizaciones pendientes

Ejecuta el siguiente comando para verificar si hay actualizaciones pendientes:

apt update && apt upgradeEsto actualizará la lista de paquetes y aplicará cualquier actualización pendiente.

Revisar antiguos repositorios de terceros

Si anteriormente tenías repositorios de terceros, revisa si hay actualizaciones disponibles para ellos. Puedes volver a añadirlos al directorio /etc/apt/sources.list.d/, asegurándote de que sean compatibles con Debian 13.

Podrías usar la herramienta apt modernize-sources para actualizar automáticamente los repositorios de terceros:

apt modernize-sourcesCambio de hostname

Si deseas cambiar el nombre de tu máquina (hostname), puedes hacerlo editando el archivo /etc/hostname y /etc/hosts. Asegúrate de reiniciar el sistema para que los cambios surtan efecto.

hostnamectl set-hostname debian13Reconfiguración de paquetes

Si has instalado paquetes que requieren reconfiguración, puedes hacerlo con el siguiente comando:

dpkg-reconfigure locales

dpkg-reconfigure tzdataVerificar servicios

Después de la actualización, es importante verificar que todos los servicios estén funcionando correctamente. Puedes usar el siguiente comando para ver el estado de los servicios:

systemctl list-units --type=serviceReiniciar el sistema

Una vez que hayas completado todos los pasos anteriores, es hora de reiniciar tu sistema para que los cambios surtan efecto. Puedes hacerlo con el siguiente comando:

reboot-

Bono de $1000 – Programa Incentivo Emprende https://multiayuda.com/bono-de-1000-programa-incentivo-emprende/ $470 dólares Consulta si eres b...

-

Lista de socios productores de rosas en Ecuador , usted puede revisar , nombre de la empresa, teléfono y la dirección, da clic en el siguie...